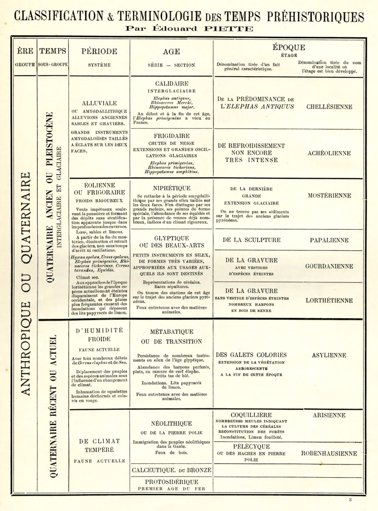

Classer le vivant : entre rigueur latine et flou évolutionniste etreyz mar 16/09/2025 - 00:00 Diane Dabir-Moghaddam BIOLOGISTE, PARIS Pierre Kerner GÉNÉTICIEN, PARIS Plus de 47 000 espèces sont aujourd'hui menacées d'extinction. Mais encore faut-il savoir ce qu'on entend par «espèce». Derrière ce mot central en biologie se cache un concept bien plus fuyant qu'il n'y paraît, débattu depuis plus de deux mille ans. Selon que l'on se place du point de vue de l'écologie, de la génétique ou de la morphologie, la définition évolue, chacune avec ses avantages et ses angles morts. Les biologistes disposent ainsi de plusieurs outils. Problème: aucun n'embrasse parfaitement la diversité du vivant. (1) T. Matthews et al., Science, 386, 6717, 2024. (2) tinyurl.com/HeritageLinne (3) E. Mayr, Systematics and the Origin of Species, 1942 ; K. de Queiroz, PNAS, 2, 6600, 2005. (4) G. Constable et H. Kokko, Nat. Ecol. Evol., 2, 1168, 2018. (5) ial-lichenology.org (6) J. Staley, Philos. Trans. R. Soc. Lond. B. Biol. Sci., 361, 1475, 2006. (7) J. Fennessy et al., Curr. Biol., 26, 2543, 2016 ; IUCN-girafes (8) M. Root-Bernstein, Qu'est-ce qu'une espèce ?, humenSciences, 2025. (9) J. Borgelt et al., Communic. Biol., 5, 679, 2022. 80 Histoire des sciences Lundi 27 octobre 2025 - 11:59 Gratuit 2099 3 Ajouter au flux RSS 1 À en croire les chiffres compilés par l'Union internationale pour la conservation de la nature (UICN), sur les 169 400 espèces évaluées à ce jour, plus de 47 000 sont menacées d'extinction en raison des activités humaines. Et l'hécatombe ne date pas d'hier: une étude récente a ainsi révélé la disparition de 610 espèces d'oiseaux ayant accompagné l'essor de l'humanité au cours de ces 130 000 dernières années (1). On pense immédiatement à l'iconique dodo ou dronte de l'île Maurice (Raphus cucullatus), éradiqué vers la fin du XVIIe siècle par les colons européens et leurs activités, moins d'un siècle après sa découverte. Or, la biodiversité et sa santé reposent sur cette unité fondamentale qu'est l'espèce - une notion pourtant difficile à cerner. Comme le «vivant», qu'aucun biologiste ne définit vraiment mais que tous étudient, l'espèce reste insaisissable malgré son rôle central dans les sciences, l'écologie et la politique. À première vue, le concept semble simple: le mot vient du latin species, «apparence» et, pour Aristote, au IVe siècle avant notre ère, une espèce se définit par sa reproduction fidèle – les chiens engendrent toujours des chiens. Cette définition traversera les siècles, reprise notamment par le naturaliste suédois Carl von Linné (1707-1778) qui la cristallise en essayant d'attribuer un nom, binominal et en latin, à toutes les espèces vivantes. La construction est toujours la même: il juxtapose toujours un genre et une épithète spécifique. La vache, par exemple, est appelée Bos taurus, où Bos est le nom de genre, et taurus, son épithète spécifique. Cette manière de dénommer les espèces s'accompagne de quelques conventions : on écrit toujours les noms en italique ou soulignés, et seule la première lettre du nom de genre doit être en majuscule, le reste est en minuscule ; lorsqu'on abrège un nom d'espèce, on peut ne garder que cette majuscule suivie d'un point – pas de tiret ! –, donnant B. taurus, pour reprendre notre exemple, ou T. rex, pour parler du théropode le plus charismatique du cinéma. L'avantage de cette nomenclature binomiale est d'indiquer immédiatement la place d'une espèce dans le grand arbre du vivant. Linné élabore ainsi la première classification hiérarchique, le Systema naturæ, où chaque espèce appartient à un genre, chaque genre à une famille, puis à un ordre et à un règne. Même si ces catégories, souvent arbitraires, sont aujourd'hui progressivement abandonnées, l'espèce reste l'unité de base de la classification du vivant. SEPT «APÔTRES» DE LINNÉ ONT PÉRI AU COURS D'EXPÉDITIONS En vue de découvrir de nouvelles espèces, Linné a formé (et disons-le, exploité) de nombreux étudiants brillants de l'université d'Uppsala (Suède) en les envoyant, à partir de 1741, pour des expéditions au nom du groupe qu'il a lui-même baptisé «les apôtres de Linné». Ces expéditions étaient périlleuses: sept moururent en mission, ce qui poussa Linné à ne recruter que des célibataires. Certains voyagèrent loin, comme Pehr Löfling en Amérique du Sud, ou Daniel Solander qui accompagna James Cook en Océanie. Carl Peter Thunberg, pour sa part, réussit à pénétrer le Japon à l'époque où le pays était fermé aux étrangers. Au total, Linné et ses dix-sept disciples auraient décrit environ 12 000 espèces (2). Toutes n'ont pas survécu à l'épreuve des découvertes postérieures, comme celles du genre Lacerta, qui regroupait à l'époque aussi bien des lézards que des crocodiles, alors que nous savons aujourd'hui qu'ils ne sont pas exclusivement apparentés. Mais cette nomenclature classique ne dit toujours pas ce qu'est une espèce. Pour Linné et la plupart des naturalistes du XVIIIe siècle, la réponse était simple: le monde vivant est fixe. Chaque espèce correspond à une catégorie immuable, et les différences observées entre individus ne sont que des écarts accidentels. Derrière ce fixisme se cache l'idée – séduisante mais fausse – d'un vivant stable et immuable. LA SÉLECTION NATURELLE ASSOCIÉE AU CONCEPT DE VARIATION Au XIXe siècle, tout bascule. Des naturalistes tels que Jean-Baptiste Lamarck en France, Alfred Russel Wallace et Charles Darwin en Angleterre défendent une vision radicalement différente: les variations entre individus ne sont pas négligeables. Pour eux, elles démontrent que les espèces évoluent au fil des générations. Cette proposition est un bouleversement : pour la première fois, on envisage les espèces dans une dimension temporelle – ce qui rend instable sa définition. Et ce n'est pas tout. Wallace et Darwin complètent cette réflexion en associant au concept de variation celui de la sélection naturelle: dans une population, les individus les mieux adaptés à leur environnement survivent et se reproduisent davantage, transmettant leurs caractères avantageux à leur descendance. Cela explique pourquoi, au sein d'une même espèce, certains individus portent des caractères avantageux qui, génération après génération, sont favorisés par la sélection naturelle, modifiant peu à peu la forme de la population. Variation et sélection naturelle constituent, de manière très simplifiée, les piliers de la théorie de l'évolution. Par la suite, tout l'enjeu pour les biologistes sera de réconcilier le concept d'espèce avec la théorie évolutionniste du vivant. C'est l'une des entreprises du biologiste germano-américain Ernst Mayr qui, en 1942, propose la «définition biologique de l'espèce», devenue l'une des plus répandues chez les taxonomistes (les scientifiques qui classent et nomment les êtres vivants). Selon lui, «les espèces sont des groupes de populations naturelles qui sont effectivement ou potentiellement interfécondes, et isolées [notamment génétiquement] d'autres groupes» (3). Sur le papier, cette définition paraît simple : si les descendants d'une population sont capables de se reproduire à leur tour, et qu'ils ne remplissent pas ces critères avec une autre population, alors il s'agit bien de deux espèces différentes. Toutefois, cette définition, en apparence idéale, se heurte vite à la réalité du terrain. Il peut arriver, par exemple, que les individus accessibles aux scientifiques au moment de l'étude ne soient plus féconds – comme des femelles en fin de vie – ou qu'il ne s'y trouve que des mâles. Par ailleurs, si la plupart des espèces présentent deux types sexuels, certains champignons possèdent des systèmes de reproduction beaucoup plus complexes. Ainsi, une espèce de petits champignons blancs poussant sur le bois mort, Schizophyllum commune, compte plus de 23 000 types sexuels différents, qui ne sont pas tous compatibles entre eux (4). Dans ces conditions, il est évidemment impossible de tester toutes les combinaisons de croisements. D'autres champignons mettent également à mal cette définition biologique, notamment lorsqu'ils forment des assemblages symbiotiques. C'est le cas des lichens qui, tels que définis par l'Association internationale de lichénologie (5), sont constitués d'un (ou de plusieurs) champignons associés à un partenaire photosynthétique (algues unicellulaires ou bactéries). Cette redéfinition a représenté une véritable révolution conceptuelle. Jusqu'à la fin du XIXe siècle, les lichens étaient considérés comme des organismes proches des plantes, regroupés dans leur propre genre. Mais l'accumulation de données a conduit à les concevoir comme des assemblages d'espèces distinctes – champignons, algues, bactéries –, formant ce que l'on appelle désormais des holobiontes ou supraorganismes. En d'autres termes, les lichens apparaissent de plus en plus comme de véritables écosystèmes, impossibles à réduire à une unique dénomination binominale en latin. LE PROCESSUS DE TRANSFERT GÉNÉTIQUE HORIZONTAL De surcroît, nombre de lichens abritent des partenaires bactériens qui, eux-mêmes, défient la définition biologique de l'espèce. Les bactéries regroupent en effet une multitude d'organismes unicellulaires se reproduisant principalement de façon asexuée, mais capables d'échanger des gènes entre populations très différentes – un processus appelé transfert génétique horizontal (par opposition au transfert vertical lié à la descendance). Dans ce contexte, les microbiologistes classent les bactéries selon divers critères moléculaires, toujours un peu arbitraires. L'un d'eux repose sur le taux d'hybridation de l'ADN entre deux souches: si la complémentarité entre leurs séquences est inférieure à 70 %, elles sont considérées comme appartenant à deux espèces différentes. Ce critère est devenu célèbre car, appliqué aux primates, il conduirait... à tous les classer dans une seule et même espèce (6). Pour toutes ces raisons, la notion d'espèce ne peut pas se limiter au concept biologique. Les scientifiques doivent mobiliser d'autres approches, plus adaptées selon les cas. Prenons la définition morphologique, par exemple. Proche des réflexions d'Aristote, elle considère que deux individus dont la morphologie est suffisamment semblable appartiennent à la même espèce. Cette définition se révèle particulièrement utile pour identifier des espèces disparues, puisqu'il est évidemment impossible de tester leur capacité d'hybridation. Mais elle présente aussi de sérieuses limites, en particulier face aux espèces dites cryptiques, espèces différentes qui se ressemblent tellement qu'on ne peut pas les distinguer à l'oeil nu. Ainsi, la pipistrelle commune (Pipistrellus pipistrellus) et la pipistrelle soprane (Pipistrellus pygmaeus) sont presque indiscernables morphologiquement, mais elles ne peuvent pas se reproduire entre elles. À l'inverse, certaines espèces présentent une variabilité morphologique impressionnante: leurs individus semblent très différents, tout en remplissant les critères de la définition biologique de l'espèce. C'est le cas du chien (Canis lupus) et de ses innombrables variétés domestiques, ou encore de la néphile dorée (Trichonephila inaurata), dont le mâle est dix fois plus petit que la femelle. Un autre type de distinction consiste à recourir à la génétique. La définition phylogénétique repose sur le prélèvement et la comparaison des séquences d'ADN d'un grand nombre de spécimens issus de différentes populations. Grâce à divers calculs, on évalue alors leur degré de proximité génétique: plus il est élevé, plus les séquences sont similaires, ce qui suggère que les organismes partagent un ancêtre commun récent. Ces analyses produisent des représentations en réseau – arbres phylogénétiques ou arbres de parenté – où apparaissent clairement des regroupements d'individus présentant de fortes similarités génétiques. Ces regroupements sont ensuite interprétés comme des unités de reproduction potentielles, pouvant correspondre à des espèces. Le séquençage génétique permet-il pour autant de clore le débat? Pas tout à fait. Il est indéniable que ces outils ont résolu de nombreuses énigmes. Tout récemment, par exemple, l'UICN a officialisé la division des girafes en quatre espèces distinctes, sur la base de l'analyse de l'ADN d'une centaine de spécimens (7). Mais cette approche n'est pas exempte de biais. L'usage exclusif du séquençage peut conduire à une surestimation du nombre d'espèces, en séparant artificiellement des groupes qui, dans la réalité, appartiennent à une même entité. Une approche qui suscite de vifs débats au sein de la communauté scientifique. Le cas des fougères est emblématique de cette inflation: là où un système de classification reconnaît 319 genres (des grands ensembles d'espèces), d'autres classifications n'en retiennent qu'environ 207. Les partisans du découpage fin y voient une meilleure reconnaissance de la diversité, tandis que leurs opposants jugent qu'un tel éclatement complique inutilement l'identification. UNE LARGE PANOPLIE DE MÉTHODES Chaque définition de la notion d'espèce comportant son lot d'inconvénients, il paraît donc illusoire d'en établir une qui soit parfaitement satisfaisante. En réalité, lorsqu'un scientifique nomme une espèce, il ne fixe pas une identité définitive: il formule une hypothèse (lire l'encadré ci-dessous). Pour l'étayer, il mobilise toute une panoplie de méthodes - anatomiques, moléculaires, comportementales, etc. Malgré tout, le vivant semble bien séparé en unités distinctes et non s'organiser en continuum. Dans son ouvrage Qu'est-ce qu'une espèce? (humenSciences, 2025), l'éthnobiologiste et écologue Meredith Root-Bernstein rappelle que «les espèces, évidemment, ne sont pas des catégories exactes. Ce n'est pas que les biologistes n'arrivent pas à percer le mystère de l'espèce, c'est que la formation des espèces distinctes est un accident de l'évolution et non un résultat inévitable de la vie, ou le but de l'évolution. L'évolution n'a pas de but et la vie sur Terre n'a pas de résultat inévitable» (8). Bien que l'on peine tant à définir clairement la notion d'espèce, celle-ci est fondamentale car étroitement liée aux enjeux de biodiversité et de conservation. Elle permet notamment de réaliser des inventaires, de mesurer la diversité biologique d'un site, ce qui sert ensuite à hiérarchiser les zones à protéger en priorité. Mais toutes les espèces sont loin d'avoir été décrites, notamment parmi les insectes et d'autres organismes discrets comme certains vers, pourtant essentiels au recyclage de la matière organique. Il en résulte que certains milieux ne bénéficient pas de la protection qu'ils mériteraient, faute d'identification complète de leurs espèces. Une étude publiée en 2022 a ainsi montré que la conservation de régions sud-américaines riches en biodiversité pourrait être renforcée de 20 % si l'on tenait compte des espèces encore non répertoriées faute de données (9). Cette problématique soulève une interrogation de fond: est-il réellement pertinent de fonder la protection de la biodiversité uniquement sur la notion d'espèce? Attendre qu'une espèce soit découverte et jugée digne de protection avant d'agir revient à retarder la préservation des milieux naturels. Il semble plus cohérent de protéger directement les écosystèmes, sachant qu'il est chimérique de connaître l'intégralité des espèces qui les peuplent. De la même manière que pour la notion de «vivant», dont l'absence de définition consensuelle n'empêche ni l'étude scientifique, ni l'urgence de le protéger, l'indétermination du concept d'espèce ne devrait pas freiner nos efforts de conservation. Crédit : J. Vigne / La Collection Parution product Au cœur des atomes Diane Dabir-Moghaddam BIOLOGISTE, PARIS Doctorante au laboratoire de l'Institut de systématique, évolution, biodiversité du Muséum national d'histoire naturelle à Paris. Pierre Kerner GÉNÉTICIEN, PARIS Enseignant-chercheur en génétique évolutive du développement à l'université Paris Cité et à l'Institut Jacques-Monod. Serait-ce une nouvelle espèce ? Vous pensez avoir découvert un organisme inconnu du monde vivant? Et s'il s'agissait d'une nouvelle espèce! Pour la décrire officiellement, il vous faudra réunir quatre ingrédients: un type (le spécimen de référence), une description complète, une solide expertise du groupe étudié, et enfin un peu d'imagination pour lui trouver un nom inédit. Le type est le spécimen «porte-nom»: c'est à lui que l'on se référera si l'espèce doit un jour être redéfinie ou comparée à de nouveaux individus. Avec un seul spécimen, on parle d'holotype et avec une série, il s'agit de syntypes (souvent déposés dans différents musées ou collections pour plus de sécurité). Le type doit être accessible à tout chercheur, sinon il ne peut pas être utilisé pour comparaison, et l'espèce n'est pas valide. La description et le nom doivent ensuite être publiés dans un support reconnu: de nos jours, principalement des revues scientifiques spécialisées. Cette description doit être la plus détaillée possible: aspect général, critères de distinction (la «diagnose»), répartition géographique, biologie, saisonnalité, et parfois même un extrait de séquence génétique pour faciliter les comparaisons. Enfin, le nom choisi doit être formé avec les 26 lettres de l'alphabet latin. Il peut provenir d'un mot existant, d'une dérivation ou être inventé de toutes pièces, mais il doit être absolument inédit. Sinon, la nouvelle espèce n'est pas valide. Les règles officielles sont édictées dans plusieurs codes internationaux: l'ICZN (International Code of Zoological Nomenclature) pour les animaux, l'ICN (International Code of Nomenclature for algae, fungi and plants) pour les plantes, algues et champignons, et l'ICNP (International Code of Nomenclature of Prokaryotes) pour les bactéries et archées. D. D.-M. 85 % DES AMPHIBIENS mal évalués sont menacés. Parmi les espèces classées « données insuffisantes » par l'Union internationale de la conservation de la nature, la grande majoritédes amphibiens (grenouilles, salamandres, crapauds) sont en réalité menacés d'extinction.