L'année 2025 en dix événements marquants dans le monde

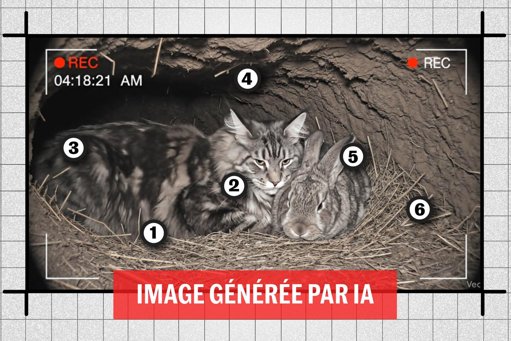

Par AFP Par Pascale JUILLIARD et les bureaux de l'AFP © 2025 AFP Retour au pouvoir de Donald Trump, fragile cessez-le-feu à Gaza ou enlisement de la guerre en Ukraine, voici dix événements qui ont marqué l'année 2025.- Donald Trump, le tonitruant retour - Offensive protectionniste, expulsions massives d'immigrés en situation irrégulière, démantèlement de pans entiers de l'Etat fédéral ... Depuis son retour en janvier à la Maison Blanche pour un second mandat, le Républicain Donald Trump a pris une salve de mesures conformes à sa doctrine "l'Amérique d'abord", à grand renfort de décrets, même si un certain nombre de ses décisions ont été bloquées par la justice.Agissant, selon ses opposants, au mépris des droits fondamentaux et des autres lieux de pouvoir, il a ciblé ses adversaires, envoyé des gardes nationaux dans plusieurs grandes villes démocrates, s'est employé à intimider les médias, a bataillé contre les programmes de diversité ou d'inclusion. Il a aussi déployé une intense activité diplomatique, avec plus ou moins de succès.Les sondages montrent cependant un mécontentement croissant des Américains sur les questions économiques, notamment le coût de la vie. De cuisants revers lors de scrutins locaux mettent son parti dans une posture délicate pour les élections de mi-mandat à l'automne 2026.- Trêve précaire à Gaza - Les pressions américaines ont débouché sur un cessez-le-feu entre Israël et le Hamas, deux ans après le début de la guerre dévastatrice dans la bande de Gaza, déclenchée par l'attaque inédite du mouvement islamiste palestinien sur le sol israélien le 7 octobre 2023.Cette trêve a permis un retrait partiel des troupes israéliennes de la bande de Gaza, l'échange des derniers otages retenus vivants à Gaza contre des prisonniers palestiniens détenus par Israël, et une entrée accrue d'aide humanitaire à Gaza, même si elle est toujours très en-deçà des besoins selon l'ONU et plusieurs ONG.Israël attend le retour d'un dernier corps d'otage avant d'entamer les tractations sur la deuxième phase de la trêve, étape qui aux termes d'un plan américain validé par l'ONU doit conduire à la démilitarisation de Gaza. Le Premier ministre israélien Benjamin Netanyahu a dit espérer passer "très bientôt" à cette deuxième étape mais des violences continuent de secouer le territoire, les deux parties s'accusant mutuellement de violer la trêve.Les tensions régionales perdurent avec la poursuite des frappes israéliennes dans les bastions du mouvement chiite Hezbollah au Liban. L'Iran avait également été frappé par des raids israéliens et américains sur ses installations nucléaires lors d'une guerre de douze jours avec Israël en juin, déclenchée par une attaque israélienne. En septembre, ce sont des responsables du Hamas qu'Israël avait ciblé dans une attaque sans précédent au Qatar.- Efforts laborieux de paix en Ukraine - Le retour au pouvoir de Donald Trump a marqué les premiers efforts sérieux visant à mettre fin à l'invasion russe de l'Ukraine lancée en février 2022.Les sympathies et blâmes du président américain ont oscillé entre Vladimir Poutine et Volodymyr Zelensky. En février, Donald Trump a vilipendé le président ukrainien devant les caméras dans le bureau ovale, lui reprochant de manquer de gratitude envers les Etats-Unis.Des pourparlers directs entre Russes et Ukrainiens à Istanbul puis une rencontre au sommet entre Donald Trump et Vladimir Poutine en Alaska n'ont débouché sur aucune avancée concrète vers la paix, et Washington a annoncé en octobre des sanctions contre le secteur pétrolier russe.Des négociations internationales se sont cependant tenues fin novembre sur la base d'un projet de plan américain, dont la version initiale avait été considérée par Kiev et ses alliés européens comme largement favorable à Moscou.Après un nouveau cycle de pourparlers avec les émissaires de Trump en décembre, l'Ukraine a déclaré que des "progrès" avaient été accomplis, même si la question des territoires ukrainiens contrôlés par la Russie demeure un point de blocage.Sur le front, l'armée russe a poursuivi sa lente avancée dans l'est, après avoir totalement repoussé en mars les forces ukrainiennes de la région russe frontalière de Koursk. Moscou a multiplié les frappes sur les infrastructures énergétiques et le réseau ferroviaire ukrainiens, tandis que Kiev ciblait des installations pétrolières en Russie.- Guerre commerciale mondiale - Arguant d'échanges commerciaux défavorables à son pays, Donald Trump a mis en place, en plusieurs vagues, des surtaxes sur les produits importés aux Etats-Unis, variant selon les pays ou zones d'origine. Il a aussi imposé des droits de douane spécifiques sur des secteurs jugés stratégiques (acier, aluminium ou cuivre).Tandis que les pays visés envisageaient ou mettaient en oeuvre des représailles commerciales, d'âpres négociations ont été engagées, débouchant sur de nombreux accords, comme avec l'Union européenne ou, fin octobre, avec la Chine, marquant le début d'une trêve dans un conflit qui a ébranlé l'économie mondiale.Les négociations bilatérales ont en revanche été suspendues avec le Canada après une publicité antiprotectionniste jugée offensante par le président américain.Sous pression pour faire baisser le coût de la vie pour les Américains, Donald Trump s'est résolu mi-novembre à annuler des droits de douane sur certains produits alimentaires, comme le café ou le boeuf importés.- Un nouveau pape, Léon XIV - Robert Francis Prevost est devenu le 8 mai, à 69 ans, le premier pape américain, après le décès de son prédécesseur François dont il était un conseiller très écouté. La fumée blanche annonçant l'élection du 267e chef de l'Eglise catholique s'est élevée au-dessus de la chapelle Sixtine au terme d'un court conclave des cardinaux, ayant duré moins de 24 heures.Souriant et discret, ce natif de Chicago, classé parmi les cardinaux modérés, a pris le nom de Léon XIV. Le nouveau souverain pontife, qui fut pendant près de 20 ans missionnaire au Pérou dont il a pris la nationalité, s'est inscrit dans la lignée de son prédécesseur argentin avec une teinte résolument sociale, en faveur des pauvres, des migrants et de l'écologie. Il a parallèlement donné des gages aux milieux conservateurs, ré-autorisant la tenue d'une messe traditionaliste au Vatican après trois ans de restrictions. Il a exclu à court terme l'ordination de femmes diacres ou la reconnaissance du mariage homosexuel.- Soulèvements de la génération Z - En Asie, Afrique ou Amérique latine, les jeunes de la génération Z (moins de 30 ans) ont multiplié les mobilisations contre les conditions de vie, le blocage des réseaux sociaux ou la corruption des élites.Ils ont défilé au Pérou contre l'insécurité croissante et la classe politique, ou au Maroc où les autorités se sont engagées à des efforts dans des domaines sociaux, mais ont engagé des poursuites contre plus de 2.000 personnes. Dans d'autres pays, les protestations, violemment réprimées, se sont muées en une contestation plus large du pouvoir en place: après des émeutes au Népal, le Premier ministre maoïste K.P. Sharma Oli n'a eu d'autre choix que de démissionner. A Madagascar, le mouvement a conduit au renversement par l'armée du président Andry Rajoelina, qui a fui à l'étranger. En Tanzanie, les jeunes ont largement participé aux manifestations post-électorales, matées dans le sang.Le drapeau pirate du manga One Piece (une tête de mort coiffée d'un chapeau de paille), souvent arboré par les manifestants, est devenu sous l'impulsion des réseaux sociaux un symbole de la lutte contre l'oppression sur plusieurs continents.- Investissements colossaux dans l'IA - Les géants technologiques et startups spécialisées ont dépensé des sommes toujours plus colossales pour financer la croissance effrénée de l'intelligence artificielle (IA). Selon le cabinet américain Gartner, les dépenses mondiales dans l'IA devraient atteindre environ 1.500 milliards de dollars en 2025 (+50% en un an) et dépasser les 2.000 milliards l'an prochain. Les valorisations boursières faramineuses du secteur - celle du géant américain des puces Nvidia a un temps grimpé à un niveau inédit de plus de 5.000 milliards de dollars - font cependant craindre aux marchés une possible bulle spéculative.Les inquiétudes suscitées par l'IA ont par ailleurs été alimentées par de nouveaux exemples de désinformation, des accusations de violation de droits d'auteur ou des licenciements massifs, chez Amazon notamment.Les parents d'un adolescent californien qui s'est suicidé ont même accusé l'assistant IA d'OpenAI, ChatGPT, d'avoir encouragé son geste avec des conseils précis. La startup a depuis renforcé les contrôles parentaux, tandis que la Californie a promulgué une législation régulant les agents conversationnels, ou "chatbots".- Spectaculaire cambriolage au Louvre - Le 19 octobre, des malfaiteurs vêtus de gilets d'ouvriers s'introduisent en plein jour, au moyen d'un monte-charge servant d'ordinaire à des déménagements, dans le prestigieux musée parisien du Louvre après avoir brisé une vitre. Ils découpent à la disqueuse des vitrines et y dérobent des joyaux de la Couronne estimés à 88 millions d'euros, le tout en huit minutes.En prenant la fuite en scooter, ils laissent tomber la couronne de l'impératrice Eugénie (épouse de Napoléon III) qui sera retrouvée endommagée.Ce casse spectaculaire est commenté dans le monde entier et met en lumière les failles sécuritaires du plus célèbre musée de la planète.Quatre hommes soupçonnés d'avoir composé le commando ont été inculpés et écroués, mais le butin n'a pas été retrouvé à ce jour.- Frappes américaines dans les Caraïbes et le Pacifique - Washington a déployé depuis août un important dispositif militaire au large du Venezuela, officiellement pour lutter contre le trafic de drogue à destination des Etats-Unis. Une série de frappes ont été menées ces dernières semaines dans les Caraïbes et le Pacifique contre des embarcations soupçonnées de transporter de la drogue, faisant une centaine de morts, des opérations à la légalité mise en doute par les experts. Caracas y voit un prétexte visant à renverser le président Nicolas Maduro et à s'emparer des réserves pétrolières du pays. Après avoir saisi le 10 décembre un pétrolier transportant du brut vénézuélien, Washington a annoncé un "blocus total" contre les "pétroliers sous sanctions" allant au Venezuela ou le quittant.Washington accuse Nicolas Maduro d'être à la tête d'un cartel et offre une récompense de 50 millions de dollars pour sa capture.- Evénements climatiques records - Inondations meurtrières, puissantes tempêtes... Les phénomènes météorologiques extrêmes se sont succédés, leur fréquence et leur intensité étant accentuées par le dérèglement climatique généré par l'activité humaine, selon les scientifiques.L'ouragan Melissa, l'un des plus puissants à avoir jamais balayé les Caraïbes, a dévasté des régions entières de la Jamaïque et inondé Haïti et Cuba. En Asie du Sud-Est, les Philippines ont été frappés en moins de deux mois par les typhons Ragasa, Kalmaegi et Fung-wong. Le Vietnam a été meurtri par des tempêtes, inondations et glissements de terrain, tandis que deux tempêtes tropicales ont fait des centaines de morts en fin d'année au Sri Lanka et en Indonésie.Alors que les températures grimpaient, les feux de forêt se sont intensifiés en Europe, avec un nombre record d'hectares brûlé pendant l'été. Le pourtour méditerranéen français a connu son pire incendie depuis 50 ans.Aux Etats-Unis, des feux déclenchés par la foudre ont entraîné mi-juillet la fermeture de la rive nord du célèbre Grand Canyon (Arizona) pour le reste de la saison touristique.burs-jc-paj/maj-ang/jco